Si estás interesado en el mundo del Big Data, seguramente ya sabes qué es Apache Spark.

Durante el siglo XXI se ha generado una abrumadora cantidad de información. Esto se debe, en gran parte, a la revolución digital. Con la democratización del internet y la migración digital masiva, tanto de las personas como de las empresas, la huella digital de la humanidad ha tenido un enorme aumento.

Se calcula que solamente en los últimos dos años se ha creado el 90% de toda la información existente en el mundo. Es por eso que, en este contexto, el término macrodatos o Big Data ha adquirido una importancia fundamental y, en los últimos años, Spark ha revolucionado la manera en la que se trabaja con cantidades tan grandes de información y conjuntos de datos.

Pero si aún no eres un experto en este tema y estás pensando en convertirte en un analista de datos, no te preocupes. Aquí te diremos todo lo que tienes que saber sobre la herramienta Spark para Big Data, así como su valor, utilidad e impacto en el procesamiento, análisis y visualización de data a gran escala.

¿Qué es Big Data?

Aunque el Big Data tiene una historia reciente, hoy se escucha este término por todas partes. Se dice, entre otras cosas, que en este campo se encuentra el empleo del futuro y que el éxito de las empresas hoy depende del análisis de macrodatos, que les permite generar productos y servicios basados en ellos.

¿Pero qué quiere decir exactamente Big Data y por qué es importante?

Podemos definir este concepto en rasgos generales como un gran volumen de datos tan variados y complejos que requieren de formas innovadoras y rentables de procesamiento para tomar decisiones, diseñar campañas y mejorar procesos, entre otras implementaciones.

Sin embargo, no se trata sólo del volumen de los datos, sino de la variedad de fuentes y la velocidad a la que se generan. Por tal motivo su análisis se vuelve tan complejo. De ahí la importancia de Spark, una de las herramientas más utilizadas para el análisis de Big Data, y quizá la más eficaz.

Fuente: Freepik.

¿Qué es Apache Spark?

Spark es un motor de código abierto para el procesamiento y análisis de información a gran escala (es decir, de lo que se conoce como Big Data) que se puede descargar en su sitio web.

Aunque fue creado originalmente en 2009 por el AMPLab de la Universidad de California, en Berkeley, la base de código de Spark fue donada a la Apache Software Foundation —que es la empresa de software de open source más grande del mundo— en 2014, por esa razón se le conoce como Apache Spark.

La existencia de Spark responde a las necesidades que impone actualmente el análisis de Big Data, es por eso que ofrece un motor unificado con un sistema de procesamiento paralelo o distribuido a través de clusters de computadoras que permite realizar una variedad de tareas con macrodatos a una mayor velocidad debido, entre otras razones, al conjunto de bibliotecas que incluye y que pueden usarse en combinación.

La velocidad a la que procesa la información es precisamente una de las características de Spark más importantes, ya que puede hacerlo de 10 (si lo hace en disco) a 100 veces más rápido (cuando lo hace en memoria) que otras herramientas, como MapReduce.

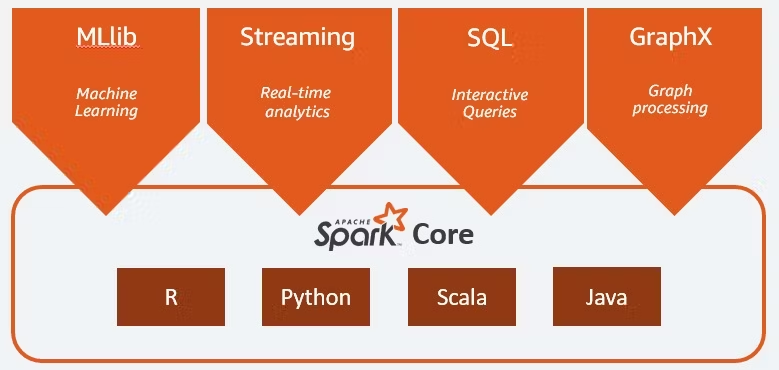

Por otro lado, Apache Spark admite múltiples lenguajes de programación altamente utilizados, (como son Python, Java, Scala, SQL y R) para programar aplicaciones paralelas rápidamente con más de 80 operadores.

Además, puede ser usado por sí solo o en plataformas como Hadoop, EC2, YARN y Mesos, así como acceder a datos desde Cassandra, Alluxio, HDFS, Hive y cientos de otras bases de datos.

Por todos estos factores relacionados con el manejo de Big Data, Spark tiene una gran popularidad entre los científicos de datos y las empresas que tienen un enfoque data-driven.

Actualmente esta herramienta forma parte de los procesos internos de algunas de las empresas más grandes del mundo con una cultura data-driven, tales como Amazon, IBM, Groupon, Ebay, TripAdvisor, NASA, Yahoo y Shopify, entre muchas otras.

Fuente: Apache Spark (infog).

¿Cómo funciona Spark con Big Data?

A grandes rasgos, Apache Spark responde a una arquitectura jerárquica de maestro/esclavo. El Spark driver es el nodo maestro que convierte el código del usuario en diversas tareas que pueden ser distribuidas entre los nodos de workers y entrega los resultados de los datos. A partir de ese funcionamiento básico se desprenden distintos elementos:

Núcleo (Spark Core)

Es la base para todos los procesamientos de datos paralelos y se ocupa de las siguientes funciones:

- Administración de la memoria y recuperación de fallas.

- Planificación, distribución y monitoreo de tareas en un cluster.

- Interacción con sistemas de almacenamiento.

- Abstracción de datos y RDD

El núcleo de Spark también es la base funcional de las bibliotecas (Spark SQL, Spark Streaming, MLlib y GraphX).

RDD

Los Resilient Distributed Datasets (RDD), concepto que podría traducirse como “conjuntos de datos resilientes distribuidos”, son una estructura fundamental de Spark para Big Data. Se trata de colecciones de elementos almacenados en memoria con tolerancia a fallas que pueden ser distribuidos entre múltiples nodos de un cluster y trabajados paralelamente, lo cual permite que su procesamiento sea rápido y escalable.

Spark SQL

Quizá es la interfaz más utilizada por desarrolladores de Spark para crear aplicaciones. Se centra en el procesamiento de datos estructurados y permite consultar macrodatos desde otras fuentes, como nos enseña José Manuel Incera Rosas en su curso de SQL para el análisis de datos.

Spark Streaming

Permite procesar flujos de datos escalables y tolerantes a fallas casi en tiempo real.

MLlib

Es una biblioteca de algoritmos para realizar operaciones enfocadas al Machine Learning.

GraphX

Además de ofrecer una serie de operaciones para la manipulación de grafos, provee algunos algoritmos de grafos como PageRank.

Fuente: amazonaws.

Spark vs. Hadoop

Si bien suelen oponerse estas dos plataformas de análisis de Big Data, en realidad debemos considerar a Spark como una mejora de Hadoop, y, de manera más específica, de su componente nativo para el procesamiento de datos, MapReduce.

Igual que Spark, MapReduce también permite a desarrolladores crear aplicaciones para procesar Big Data más rápidamente en porciones que trabajen en paralelo a través de clusters.

Sin embargo, la diferencia estriba en que MapReduce procesa sus datos en disco, lo cual ralentiza el proceso al añadir tiempo de lectura y escritura de información. Por su parte, como se ha dicho, Spark opera en memoria, lo cual agiliza significativamente los procesos.

Otra de las diferencias entre estas dos plataformas radica en las posibilidades que ofrecen para programar aplicaciones. Es mucho más complicado programar en MapReduce que en Spark, debido a los APIs que contiene para distintos lenguajes de programación.

Apache Spark puede ejecutar aplicaciones de procesamiento de flujos en clusters de Hadoop a través de YARN (el recurso de Hadoop para administrar recursos y programar tareas). Además, Spark permite el uso de datos provenientes de fuentes externas a Hadoop, tales como Kafka.

En suma, Spark no solo es compatible con Hadoop, sino que le es complementario y, por lo tanto, deberían ser vistas como herramientas que suman y no que se oponen.

Da tus primieros pasos en el análisis de data con esta plantilla para crear reportes

de social media.

Usos de Spark

Algunos ejemplos del uso de los API de Spark dan cuenta de la diversidad de opciones que esta herramienta ofrece. Pero ahora veamos algunos casos en los que se ha usado Spark para el análisis de Big Data aplicada a los negocios en la vida real.

- Pinterest. Por medio de Spark Streaming, Pinterest puede conocer el modo en que los usuarios de todo el mundo reaccionan ante ciertos “pins” en tiempo real. De esta manera, el algoritmo puede hacer recomendaciones personalizadas que se basan en las interacciones previas de cada usuario y les ofrecen productos cuya probabilidad de compra es más alta debido a este análisis de metadatos.

- Conviva. Se trata de la segunda compañía de transmisión de videos, después de YouTube. Conviva utiliza Spark para optimizar el tráfico de videos en vivo y reducir la rotación de los mismos, mejorando la experiencia de visualización de los usuarios.

- Uber. Todos los días esta empresa reúne terabytes de información de los viajes de sus usuarios. Con Kafka, HDFS y Spark Streaming logra procesar todos esos datos no estructurados y transformarlos en datos estructurados que luego son sujetos a análisis más complejos mediante Spark.

- Yelp. Para orientar adecuadamente su publicidad, el equipo de Yelp crea modelos de predicción que les permiten determinar la probabilidad de que un usuario interactúe con sus anuncios. Utilizan Apache Spark para procesar grandes cantidades de información para crear modelos de Machine Learning con los que han incrementado no sólo los clics a su anuncios, sino sus ingresos.

Fuente: ev (unsplash).

Spark y la revolución del Big Data

En resumen, la importancia de Spark para el Big Data radica en que representa una herramienta increíblemente útil para simplificar la laboriosa y desafiante tarea de procesamiento de altos volúmenes de macrodatos, tanto estructurados como no estructurados, en tiempo real.

Al integrar de manera casi automática y sin un esfuerzo mayor una serie de elementos —como el Machine Learning y los algoritmos de grafos— que facilitan el análisis de datos y la implementación de soluciones, brinda una ventaja competitiva sobre algunas otras de las herramientas que son usadas para analizar información a gran escala.

Aunque algunos todavía descreen del valor de los macrodatos, desconfían de su capacidad para brindar información valiosa y se enfocan en las posibles desventajas del Big Data, lo cierto es que hoy en día el análisis de datos se ha implementado con éxito en distintos sectores, desde la industria del entretenimiento o el e-commerce, hasta la seguridad y la salud.

Sin lugar a dudas, Apache Spark llegó a revolucionar el mundo del Big Data al aumentar la velocidad y la cantidad de macrodatos que pueden ser susceptibles de analizar, haciendo posible lo que hace algunos años ni siquiera era imaginable y creando soluciones, servicios o productos que responden a esos datos prácticamente en tiempo real.

Por último, siendo una plataforma de fácil acceso y tan amigable con los usuarios, Spark representa una forma de acercar el mundo del Big Data a públicos mayores. Así que esperemos que después de esta introducción te descargues Apache Spark y comiences a implementar el análisis de Big Data.

Fuente: Markus Spiske (unsplash).